Numerische Wettervorhersage

Numerische Wettervorhersagen (engl. numerical weather predictions, NWPs) sind rechnergestützte Wettervorhersagen. Aus dem Zustand der Atmosphäre zu einem gegebenen Anfangszeitpunkt wird durch numerische Lösung der relevanten Gleichungen (im trockenadiabatischen Fall: Navier-Stokes-Gleichungen, thermische Zustandsgleichung idealer Gase, Erster Hauptsatz der Thermodynamik, Kontinuitätsgleichung, im feuchtdiabatischen Fall weitere Kontinuitätsgleichungen sowie Strahlungsübertragungsgleichungen) der Zustand zu späteren Zeiten berechnet. Diese Berechnungen umfassen teilweise einen Prognosezeitraum von mehr als 14 Tagen und sind die Basis aller heutigen Wettervorhersagen. Im operationellen Betrieb werden sie zumeist durch statistische Verfahren (s. Model Output Statistics) nachbereitet.

Funktionsweise

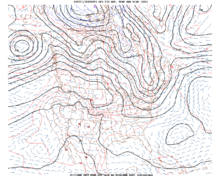

[Bearbeiten | Quelltext bearbeiten]In einem solchen numerischen Vorhersagemodell wird das Rechengebiet mit Gitterzellen und/oder durch eine spektrale Darstellung diskretisiert, so dass die relevanten physikalischen Größen, wie vor allem Temperatur, Luftdruck, Dichte, Windrichtung und Windgeschwindigkeit, im dreidimensionalen Raum und als Funktionen der Zeit dargestellt werden können. Die physikalischen Beziehungen, die den Zustand der Atmosphäre und seine Veränderung beschreiben, werden als System partieller Differentialgleichungen modelliert. Dieses dynamische System wird mit Verfahren der Numerik, welche als Computerprogramme implementiert sind, näherungsweise gelöst. Aufgrund des großen Aufwands werden hierfür üblicherweise Supercomputer eingesetzt. Es wird grundsätzlich zwischen Globalmodellen (heute ca. 10 – 50 km Maschenweite), deren Rechengebiet den ganzen Globus umfasst und Lokal- oder Ausschnittsmodellen (kurz auch LAM für limited area model) unterschieden. Letztere werden meist mit höherer Auflösung (heute ca. 1 – 15 km Maschenweite) nur auf einem begrenzten Gebiet gerechnet. Um dann die Werte am Modellgebietsrand während der Vorhersagerechnung sinnvoll festzulegen, werden üblicherweise interpolierte Ergebnisse eines Globalmodells oder großflächigeren Ausschnittsmodells verwendet (sogenanntes „Nesting“).

Parametrisierungen/Modellphysik

[Bearbeiten | Quelltext bearbeiten]Relevante Prozesse, die kleinräumiger als die Modellmaschenweite sind und nicht in dem oben erwähnten Gleichungssystem berücksichtigt sind, müssen parametrisiert werden. Die Parametrisierungen beschreiben den Effekt dieser Prozesse auf die Rechengrößen auf dem Modellgitter unter vereinfachenden Annahmen und sind fester Bestandteil des Modellcodes. Typische Parametrisierungen sind: Wolkenmikrophysik (Bildung und Veränderung von Wolken- und Niederschlagsteilchen), Strahlung, Turbulenz, Bodenmodell, Schemata für flache und hochreichende Konvektion, Reibung und chemische Prozesse. Auch Wolkenbildung die kleiner ist als die Maschenweite wird parametrisiert.[1]

Datenassimilation

[Bearbeiten | Quelltext bearbeiten]Darüber hinaus kommt der Festlegung des Anfangszustandes der Modellatmosphäre eine wichtige Bedeutung für den Erfolg der Modellvorhersage zu. Dabei wird mit unterschiedlichen mathematischen Verfahren (variationelles Verfahren wie 3D-Var, 4D-Var, Optimal Interpolation, Nudging, Kalman-Filter) eine gewichtete Kombination aus Messwerten und älteren Modellvorhersagen auf das Modellgitter interpoliert (so genannte Datenassimilation). Gemessene Größen der Fernerkundungsgeräte (Radar, Lidar, Satelliten) müssen dazu in Modellvariablen transformiert werden und umgekehrt. Konventionelle Messungen der Temperatur, der Feuchte, des Drucks usw. von Wetterstationen, Wetterballons, Flugzeugen, Schiffen und Bojen müssen lediglich räumlich und zeitlich interpoliert werden. Ferner müssen Fehlmessungen ausgesondert und systematische Messfehler (bias) korrigiert werden.[2][3]

Geschichte

[Bearbeiten | Quelltext bearbeiten]Die Möglichkeit einer numerischen Wettervorhersage wurde zum ersten Mal 1904 von Vilhelm Bjerknes in einem Vortrag gefordert, ohne dass er einen konkreten Weg zeigen konnte. Lewis Fry Richardson berechnete während des Ersten Weltkriegs (1914–1918) zum ersten Mal eine Wettervorhersage, und auch wenn das Ergebnis grotesk falsch war, konnte nach der Erfindung des Computers auf seinen Vorarbeiten aufgebaut werden. John von Neumann schlug dann 1946 vor, den Computer für diesen Zweck zu verwenden. Im März 1950 berechnete der Großrechner ENIAC zum ersten Mal eine Wettervorhersage aus tatsächlichen Wetterdaten. Durch die zunehmenden Computerressourcen und neue Erkenntnisse auf dem Gebiet der Meteorologie und Numerik konnte seither die Auflösung und Qualität der Modellvorhersagen immer weiter verbessert werden. Immer mehr Wetterdienste auch in Entwicklungs- und Schwellenländern betreiben heute eigene numerische Vorhersagen oder nutzen zumindest numerische Produkte.

Kleinräumige Prognose

[Bearbeiten | Quelltext bearbeiten]Die von den Modellen errechneten Wetterprognosen sind für eine Vorhersage des Wetters „vor Ort“ aufgrund der limitierten Modellauflösung, der Unsicherheit in den Anfangsbedingungen und der nicht-linearen Entwicklungen in der Atmosphäre („Chaos“) oft ungenau. Die errechneten Werte werden daher üblicherweise von Meteorologen auf Plausibilität überprüft, mit Erfahrungswerten abgeglichen und in Vorhersagetexte und Wetterwarnungen transformiert.

Model Output Statistics (MOS) ist ein Ansatz zur automatisierten kleinräumigen Wetterprognose. Hierbei werden die von den Modellen gelieferten Daten in Relation zu statistischen Messwertreihen gesetzt, um eine möglichst genaue Vorhersage „vor Ort“ liefern zu können. Der systematische Fehler des Modells wird mittels der Statistik vergangener Zeitpunkte (Modell- und Stationswerte) so entfernt. Im Gegensatz dazu werden beim Direct Model Output (DMO) die gelieferten Daten lediglich für die gewünschten Orte interpoliert. Neuerdings kommen neben den klassischen linearen MOS-Korrekturen auch auf Machine-Learning und künstlicher Intelligenz (AI) beruhende Korrekturverfahren zum Einsatz. Die Ersetzung von ganzen Modellparametrisierungen oder gar des ganzen Wettermodells durch AI-Ansätze ist dagegen noch im Versuchsstadium.

Ensembleprognose

[Bearbeiten | Quelltext bearbeiten]Wegen der chaotischen Natur des Wetters kann in vielen Fällen eine leichte Änderung der Ausgangsdaten insbesondere bei mittel- und langfristigen Vorhersagen zu einer völligen Veränderung der Prognose führen (Schmetterlingseffekt). Daher werden neben dem so genannten Hauptlauf, bei dem die Rechner mit den tatsächlich gemessenen Werten gefüttert werden, weitere Läufe durchgeführt, bei denen mit leicht veränderten Daten und einer etwas gröberen Auflösung der Modell-Gitterpunkte gearbeitet wird. So soll die Prognoseunsicherheit abgeschätzt werden. Die Ergebnisse dieser Läufe werden in Ensembles verglichen. Sind die Ergebnisse für einen Zeitraum der Prognose ähnlich, so ist das ein Indiz dafür, dass die Vorhersage für diesen Zeitraum relativ sicher ist. Während in einigen Fällen die Großwetterlage somit über 10 Tage recht gut prognostizierbar ist, gibt es andere Fälle, bei denen bereits nach wenigen Tagen eine zufriedenstellende Vorhersage kaum möglich ist. Die Anfangsstörungen für die einzelnen Ensemblemitglieder werden mittels zufälliger (stochastischer) Störung, Störung der assimilierten Beobachtungen zur Berücksichtigung der Messfehler (Ensembledatenassimilation), Störung in Richtung größter Störempfindlichkeit mittels sogenannter singulärer Vektoren oder Reskalierung des Auseinanderlaufens früherer Vorhersagen (breeding) generiert. In jüngerer Zeit wird auch die Unsicherheit in den Parametrisierungen während der Modellintegration durch Störung der darin enthaltenen Rechengrößen berücksichtigt (stochastische Modellphysik und Multiphysik). Globale Ensemblemodelle werden beispielsweise am EZMW, UK-Metoffice, NCEP in den USA und in Kanada sowie von Météo-France erstellt. Ensembles mit hochaufgelösten Ausschnittsmodellen wie das COSMO-DE-EPS des Deutschen Wetterdienstes kommen erst seit wenigen Jahren zum Einsatz und sind noch Gegenstand intensiver Forschung.

Modelle

[Bearbeiten | Quelltext bearbeiten]Es gibt eine Vielzahl von Modellen der verschiedenen Wetterdienste. Diese verwenden unterschiedliche numerische Methoden, Gitter und Parametrisierungen und können daher in ihrer Vorhersage erheblich voneinander abweichen. Die Modelle werden üblicherweise mindestens einmal täglich neu berechnet und starten zu den synoptischen Hauptterminen 0, 6, 12, 18 Uhr UTC.

Zu den bekanntesten Modellen gehört das globale Modell GFS (Global Forecast System, ehemals AVN) der US-amerikanischen NOAA. Es berechnet viermal täglich Vorhersagen. Die GFS-Daten sind frei erhältlich und werden daher besonders von kleinen und privaten Wetterdiensten genutzt. GFS ist in drei Teil-Modelle aufgeteilt, von denen das detaillierteste eine Prognose für alle drei Stunden der nächsten 3,5 Tage liefert und eine Gitterauflösung von etwa 40 km hat. Das langfristige Teil-Modell reicht bis 16 Tage in die Zukunft, prognostiziert das Wetter allerdings nur für alle zwölf Stunden und hat eine geringere Auflösung.

Weitere bekannte Globalmodelle sind:

- GME (Globalmodell Europa): 1999 – Februar 2015 globales Modell des Deutschen Wetterdienstes auf einem Ikosaeder-A-Gitter (ein Ikosaeder-Gitter hat dreieckige Gitterzellen)

- ICON (icosahedral non-hydrostatic global circulation model): neue Modellgeneration des Deutschen Wetterdienstes und des Max Planck-Institutes für Meteorologie auf einem Ikosaeder-C-Gitter, wird global und auf einem Europaausschnitt verwendet[4]

- UM (Unified Model) des britischen Wetterdienstes Met Office (kann sowohl global als auch als Ausschnittsmodell verwendet werden)

- IFS (Integrated Forecast System): spektrales globales Modell des EZMW (Europäisches Zentrum für mittelfristige Wettervorhersage)

- GEM: globales Modell des kanadischen Wetterdienstes

- Arpège: spektrales Globalmodell des französischen Wetterdienstes Météo-France mit variabler Auflösung innerhalb des Modellgebietes

- GSM: Spektrales Globalmodell des japanischen Wetterdienstes

- NOGAPS: globales Modell des US-amerikanischen Fleet Numerical Meteorology and Oceanography Centers

Ausschnittsmodelle (LAMs) sind z. B.:

- MM5 Mesoscale Model 5: sehr verbreitet an Universitäten, aber mittlerweile zunehmend durch WRF ersetzt

- WRF Weather Research and Forecasting Model (entwickelt in den USA): mit zwei verschiedenen Dynamikkernen ARW und NNM, letztere wird von den Ländern des SEECOOPS-Konsortiums (Serbien, Bosnien, Albanien, Mazedonien, Montenegro) operationell eingesetzt

- COSMO-Modell (früher „Lokalmodell“ LM/LME/aLMo): Ausschnittsmodell des Deutschen Wetterdienstes und des COSMO-Konsortiums (u. a. auch Meteo Schweiz, Italien, Russland, Rumänien, Polen, Griechenland und Israel), das aktuell durch ICON ersetzt wird und auch für Klimasimulationen verwendet werden kann.

- ALADIN-ALARO-AROME-HARMONIE: Spektrale Ausschnittswettervorhersagemodellfamilie von Météo-France, der ZAMG (Wien), des CHMI (Prag) und vieler weiterer europäischer Wetterdienste des ACCORD-Konsortiums

- HIRLAM: verbreitet in Skandinavien, den Niederlanden, Irland und Island (hydrostatisches Spektralmodell), das zunehmend durch HARMONIE-AROME ersetzt wird

Abgrenzung zur Klimamodellierung

[Bearbeiten | Quelltext bearbeiten]Klimamodelle haben prinzipiell denselben Aufbau wie Wettervorhersagemodelle (Diskretisierung auf einem Gitter bzw. im Spektralraum, numerische Lösung derselben physikalischen Gleichungen, Parametrisierungen). Es gibt ebenfalls Global- und Ausschnittsmodelle. Allerdings ist die Vorhersagezielsetzung (mittlerer Zustand der Atmosphäre über Jahreszeiten bis Jahrtausenden (Klima) versus möglichst exakter Zustand der Atmosphäre in den nächsten Stunden bis Tagen (Wetter)) unterschiedlich, was zu leichten Abweichungen in der Konzeption führt. In der Wettervorhersage kommt der Kenntnis des Ausgangszustands (Anfangswertproblem) mittels Datenassimilation eine bedeutende Rolle zu. Die Details einer individuellen Wettersituation verschwinden dagegen durch die zeitliche Mittelung in Klimamodellen. Diese benötigen hingegen eine möglichst genaue Kenntnis und Zukunftsprojektion der Änderung der äußeren Antriebe (Randwertproblem) wie Schwankungen in der Solarstrahlung, der Meerestemperatur (deshalb häufige Kopplung mit einem Ozeanmodell) oder der atmosphärischen Zusammensetzung (Aerosole, Treibhausgasemissionen aus natürlichen und künstlichen Quellen), der Bodenbeschaffenheit (Änderung der Vegetation durch Landwirtschaft mit Auswirkungen auf die Strahlung und den Wasserkreislauf) etc. Auch in der Klimamodellierung ist die Ensembletechnik beliebt, wobei hier ein Schwerpunkt auf der Abschätzung der Unsicherheit der genannten äußeren Antriebe liegt (Szenarien), die durch das (unbekannte) zukünftige menschliche Verhalten (Bodennutzung, Emissionen) mitbestimmt sein kann. Darüber hinaus kommt der Umsetzung der physikalischen Erhaltungssätze im Modell (Massenerhaltung, Energieerhaltung) aufgrund der langen Berechnungszeiten eine größere Bedeutung zu. Führt die Näherungslösung der Gleichungen durch die Diskretisierung beispielsweise zu einer minimalen systematischen Änderung der Atmosphärenmasse, so ist dies auf einer Skala von wenigen Stunden (Wettermodell) oft kaum relevant, während sich der Effekt bei der Rechnung über Jahrhunderte (Klimamodell) dramatisch aufaddieren kann. Die langen Rechenzeiten verlangen auch oft Kompromisse bei der Auflösung der Klimamodelle (gröbere Maschenweite), was wiederum zu Unterschieden in den zu parametrisierenden Prozessen führen kann. Dennoch können einige numerische Modelle – z. B. ICON, COSMO und ALADIN – sowohl für die Wettervorhersage als auch Klimarechnungen verwendet werden.

Ausbreitungsrechnung

[Bearbeiten | Quelltext bearbeiten]Numerische Vorhersagemodelle können auch zur Berechnung der Ausbreitung chemischer Substanzen, radioaktiver Teilchen, Staubwolken oder Vukanaschewolken verwendet werden. Dazu werden basierend auf den Modellwindfeldern Bewegungskurven (Trajektorien) berechnet, wobei man entweder ausgehend von einer bekannten Quelle und deren Intensität das betroffene Zielgebiet (Vorwärtstrajektorien) oder bei Messung einer Überwachungsstelle das Herkunftsgebiet mittels Rückwärtstrajektorien berechnen kann. Ein bekanntes solches angeschlossenes Trajektorienmodell ist z. B. Flexpart.[5] Manche Modelle erlauben auch den direkten Transport der Substanzen inklusive Umwandlungsprozesse im Modell direkt mit zu berechnen, z. B. COSMO-ART (Karlsruhe).[6] und WRF-Chem[7]. Dies spielt für die Umweltmeteorologie eine bedeutende Rolle.

Weblinks

[Bearbeiten | Quelltext bearbeiten]- Deutscher Wetterdienst

- ICON-Modell

- Seite zum IFS-Modell des EZMW (englisch)

- The GFS Atmospheric Model (englisch)

- The Weather Research and Forecasting Model (WRF) (englisch)

- Seite zum Unified Model (englisch)

- Seite zu den Modellen des japanischen Wetterdiensts (englisch)

- Seite zum HIRLAM-Modell (englisch)

- Seite zum COSMO-Modell früher LM/aLMo (englisch)

- Seite zum ALADIN-Modell (englisch)

- ALARO in Österreich

- AROME in Österreich

- Visualisierungen von Wettermodellen (COSMO-1) der ETH Zürich und MeteoSchweiz

- Meteomodelle besser verstehen

- ACC RD (englisch)

Einzelnachweise

[Bearbeiten | Quelltext bearbeiten]- ↑ Introduction to parametrization of sub-grid physical processes in the IFS. ECMWF, abgerufen am 26. Juli 2024 (englisch).

- ↑ Datenassimilation. DWD, abgerufen am 30. Juli 2024.

- ↑ Improving the handling of model bias in data assimilation. ECMWF, abgerufen am 30. Juli 2024 (englisch).

- ↑ Globalmodell ICON. Deutscher Wetterdienst, abgerufen am 31. Januar 2019.

- ↑ Quellbestimmung abgehobener Aerosolschichten mit Trajektorien- und Partikeltransportrechnungen, auf tropos.de, abgerufen am 21. April 2022

- ↑ ICON-ART und COSMO-ART, auf dwd.de

- ↑ Modeling of gas and aerosol with WRF/Chem over Europe: Evaluation and sensitivity study, auf agupubs.onlinelibrary.wiley.com