Approximate Bayesian Computation

Approximate Bayesian Computation (engl., zu dt. „Approximative Bayessche Berechnung“, abgekürzt ABC) stellt eine Klasse von Berechnungsmethoden in der Bayesschen Inferenz dar. In der modellbasierten statistischen Inferenz ist die Likelihood-Funktion von zentraler Bedeutung, da sie die Wahrscheinlichkeit der beobachteten Daten unter einem bestimmten statistischen Modell ausdrückt und somit die Unterstützung quantifiziert, die Daten Parametern und Modellen geben. Für einfache Modelle kann oft eine analytische Formel für die Likelihood-Funktion abgeleitet werden. Bei komplexeren Modellen kann eine analytische Form jedoch schwer zu finden oder aufwändig auszuwerten sein.

ABC-Methoden umgehen die Auswertung der Likelihood-Funktion (indem z. B. Stichproben aus der prior predictive distribution betrachtet werden). Auf diese Weise erweitern sie den Bereich von Modellen, für die statistische Schlussfolgerungen möglich sind. ABC-Methoden sind mathematisch fundiert, aber sie machen Annahmen und Näherungen, deren Auswirkungen beachtet werden müssen. Darüber hinaus verschärft das weitere Anwendungsgebiet von ABC die Herausforderungen in der Parameterschätzung und Modellauswahl.

ABC hat in den letzten Jahren immens an Popularität gewonnen, insbesondere für die Analyse komplexer Probleme in der Populationsgenetik, Ökologie, Epidemiologie und Systembiologie.[1]

Approximate Bayesian Computation kann als Bayessche Version der Indirekten Inferenz verstanden werden[2].

Geschichte[Bearbeiten | Quelltext bearbeiten]

Die ersten Ideen zu ABC reichen zurück in die 1980er Jahre. Donald Rubin beschrieb bei einer Erörterung der Interpretation Bayesscher Aussagen 1984 einen hypothetischen Sampling-Mechanismus, der eine Probe aus der A-posteriori-Verteilung liefert.[3] Dieses Schema war eher ein konzeptuelles Gedankenexperiment, um zu demonstrieren, welche Art von Manipulationen durchgeführt werden, wenn auf die A-posteriori-Verteilungen von Parametern geschlossen wird. Die Beschreibung des Sampling-Mechanismus stimmt genau mit der des ABC-Rejection-Schemas überein, und dieser Artikel kann als der erste angesehen werden, der die Approximative Bayessche Berechnung beschreibt. Jedoch wurde schon in den späten 1800 Jahren von Francis Galton ein zweistufiger Quincunx konstruiert, der als physikalische Implementierung eines ABC-Rejection-Algorithmus für einen einzelnen unbekannten Parameter und eine einzige Beobachtung angesehen werden kann.[4] Ein anderer vorausschauender Punkt wurde von Rubin gemacht, als er argumentierte, dass sich angewandte Statistiker bei der Bayesschen Inferenz nicht nur mit analytisch handhabbaren Modellen begnügen sollten, sondern stattdessen Rechenmethoden in Betracht ziehen, die es ihnen ermöglichen, die A-posteriori-Verteilung von Interesse zu schätzen. Auf diese Weise kann eine größere Auswahl an Modellen in Betracht gezogen werden. Diese Argumente sind im Zusammenhang mit ABC besonders relevant.

Im Jahr 1984 schlugen Peter Diggle und Richard Gratton vor, ein systematisches Simulationsschema zu verwenden, um die Likelihood-Funktion in Situationen anzunähern, in denen ihre analytische Form nicht praktikabel ist.[5] Ihre Methode basierte darauf, ein Gitter im Parameterraum zu definieren und es zu verwenden, um die Likelihood anzunähern, indem mehrere Simulationen für jeden Gitterpunkt ausgeführt wurden. Die Approximation wurde dann durch Anwendung von Glättungstechniken auf die Ergebnisse der Simulationen verbessert. Während die Idee, Simulationen für Hypothesentests zu verwenden, nicht neu war,[6][7] führten Diggle und Gratton anscheinend das erste Verfahren ein, das Simulation zur statistischen Inferenz unter Umständen verwendet, bei denen die Likelihood nicht zugänglich ist.

Die Methode von Diggle und Gratton war noch nicht genau identisch mit dem, was heute als ABC bekannt ist, da sie eher auf die Likelihood als auf die A-posteriori-Verteilung abzielte. In einem Artikel von Simon Tavaré et al. wurde zum ersten Mal ein ABC-Algorithmus für die Inferenz der A-posteriori-Verteilung vorgeschlagen.[8] In ihrer bahnbrechenden Arbeit wurde Inferenz über die Genealogie von DNA-Sequenzdaten und insbesondere das Problem der Bestimmung der A-posteriori-Verteilung der Zeit bis zum letzten gemeinsamen Vorfahren der Stichprobenpersonen in Betracht gezogen. Eine solche Inferenz ist für viele demographische Modelle analytisch unlösbar, aber die Autoren präsentierten Möglichkeiten, Koaleszenzbäume unter den mutmaßlichen Modellen zu simulieren. Eine Stichprobe von Modellparametern wurde erhalten, indem Vorschläge angenommen oder abgelehnt wurden, die auf einem Vergleich der Anzahl von Trennstellen in den synthetischen und realen Daten beruhten. Dieser Arbeit folgte eine angewandte Studie zur Modellierung der Variation des menschlichen Y-Chromosoms durch Jonathan K. Pritchard et al. mit der ABC-Methode.[9] Schließlich wurde der Begriff der Approximate Bayesian Computation (ABC) von Mark Beaumont et al. eingeführt, der die ABC-Methodik weiter ausbaute und die Eignung des ABC-Ansatzes für Probleme in der Populationsgenetik diskutierte.[10] Seitdem hat sich ABC auf Anwendungen außerhalb der Populationsgenetik wie Systembiologie, Epidemiologie und Phylogeographie ausgebreitet.

Methode[Bearbeiten | Quelltext bearbeiten]

Motivation[Bearbeiten | Quelltext bearbeiten]

Der Satz von Bayes verbindet die bedingte Wahrscheinlichkeit (oder bedingte Wahrscheinlichkeitsdichte) eines bestimmten Parameterwerts gegeben beobachtete Daten mit der Wahrscheinlichkeit von gegeben über die Regel

- ,

wo die A-posteriori-Wahrscheinlichkeit (auch bekannt als Posterior), die Likelihood, die A-priori-Verteilung von (auch bekannt als Prior), und die Evidenz (auch bekannt als Marginal-Likelihood oder Prior-Predictive-Wahrscheinlichkeit) bezeichnen.

Der Prior spiegelt Überzeugungen über wider, bevor verfügbar ist, und wird oft spezifiziert, indem eine bestimmte Verteilung aus einer Menge bekannter und handlicher Familien von Verteilungen ausgewählt wird, so dass sowohl die Auswertung des Posterior als auch die Erzeugung von zufälligen relativ einfach sind. Für bestimmte Arten von Modellen ist es pragmatischer, den Prior anzugeben, indem eine Faktorisierung der gemeinsamen Verteilung aller Elemente von verwendet wird über eine Folge ihrer bedingten Verteilungen. Wenn man sich nur für die relativen Posterior-Plausibilitäten verschiedener Werte von interessiert, kann die Evidenz ignoriert werden, da er eine Normalisierungskonstant darstellt, welche sich herauskürzt. Dies verwenden zum Beispiel MCMC-Verfahren. Es bleibt jedoch notwendig, die Likelihood und den Prior auszuwerten. Für zahlreiche Anwendungen ist es allerdings rechenintensiv oder sogar unmöglich, die Likelihood auszuwerten,[11] was die Verwendung von ABC zur Umgehung dieses Problems motiviert.

ABC-Rejection-Algorithmus[Bearbeiten | Quelltext bearbeiten]

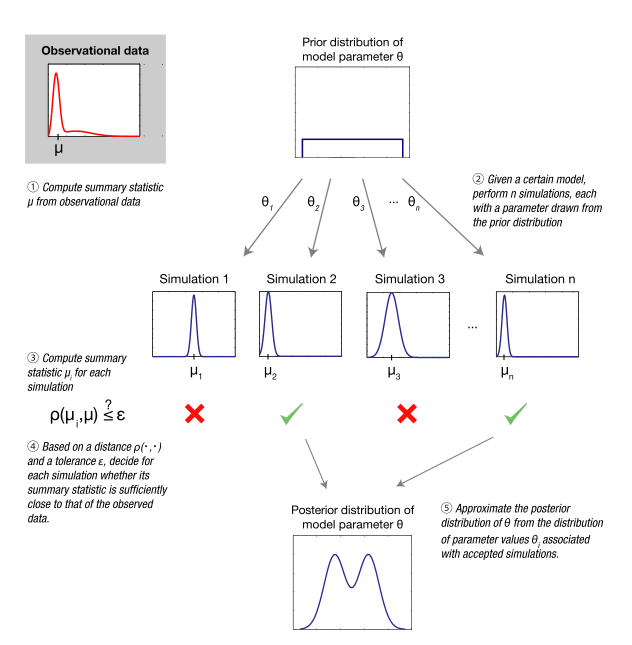

Alle ABC-basierten Methoden approximieren die Likelihood-Funktion durch Simulationen, deren Ergebnisse mit den beobachteten Daten verglichen werden.[12][13][14] Genauer gesagt wird mit dem ABC-Rejection-Algorithmus (dt. ABC-Zurückweisungsalgorithmus) – der grundlegendsten Form von ABC – zuerst eine Menge von Parametern gemäß A-priori-Verteilung gezogen. Gegeben einen zufällig gezogenen Parameter , wird dann ein Datensatz simuliert, unter dem statistischen Modell spezifiziert durch . Wenn das erzeugte zu verschieden von den beobachteten Daten ist, wird der Parameter verworfen. Konkreter wird mit Toleranz akzeptiert, wenn

- ,

wo das Distanzmaß die Diskrepanz zwischen und basierend auf einer gegebenen Metrik (z. B. Euklidischer Abstand) quantifiziert. Eine streng positive Toleranz ist (außer in diskreten Räumen) normalerweise notwendig, da die Wahrscheinlichkeit, dass das Simulationsergebnis genau mit den Daten übereinstimmt (Ereignis ) vernachlässigbar ist für alle außer trivialen Anwendungen von ABC, was in der Praxis zur Zurückweisung fast aller abgetasteten Parameterpunkte führen würde. Das Ergebnis des ABC-Rejection-Algorithmus ist eine Stichprobe von Parameterwerten, die approximativ entsprechend der gewünschten A-posteriori-Verteilung verteilt sind, und, im Wesentlichen, erhalten ohne die explizite Auswertung der Likelihood-Funktion.

Zusammenfassende Statistiken[Bearbeiten | Quelltext bearbeiten]

Die Wahrscheinlichkeit, einen Datensatz mit einem kleinen Abstand zu zu erzeugen, nimmt typischerweise exponentiell ab, wenn die Dimensionalität der Daten zunimmt. Dies führt zu einer wesentlichen Verringerung der Recheneffizienz des obigen grundlegenden ABC-Rejection-Algorithmus. Ein üblicher Ansatz, um dieses Problem zu verringern, besteht darin, durch einen Satz von geringer-dimensionalen zusammenfassenden Statistiken (engl. Summary Statistics) zu ersetzen, welche ausgewählt werden, die relevanten Informationen in zu erfassen. Das Akzeptanzkriterium im ABC-Zurückweisungsalgorithmus wird ersetzt durch

- .

Wenn die zusammenfassenden Statistiken in Bezug auf die Modellparameter suffizient sind, führt die so erzielte Effizienzsteigerung zu keinem Fehler. Definitionsgemäß bedeutet Suffizienz, dass alle Informationen in über von erfasst werden.

Typischerweise ist es außerhalb der Exponentialfamilie von Verteilungen unmöglich, einen endlichen dimensionalen Satz von ausreichenden Statistiken zu identifizieren. Dennoch werden informative, aber möglicherweise unzureichende Zusammenfassungsstatistiken häufig in Anwendungen verwendet, in denen Inferenz mit ABC-Methoden durchgeführt wird. Somit gibt es zwei Quellen für Approximationefehler bei der Verwendung von ABC zum Sampling von der A-posteriori-Verteilung: Durch den Akzeptanz-Toleranz-Parameter und durch die zusammenfassenden Statistiken .

ABC-MCMC- und ABC-SMC-Algorithmus[Bearbeiten | Quelltext bearbeiten]

Ein Nachteil des ABC-Rejection-Algorithmus ist, dass Parameterwerte direkt aus der A-priori-Verteilung gezogen werden. Sind zum Beispiel die Daten informativ, wird die A-posteriori-Verteilung deutlich konzentrierter sein, so dass viele simulierte Daten nicht gut mit den beobachteten Daten übereinstimmen, mithin wird die Akzeptanzrate gering sein. Daher ist es sinnvoll, die Parameter von einer Verteilung zu ziehen, welche (adaptiv) näher an der A-posteriori-Verteilung ist. Hierzu gibt es im Wesentlichen zwei Wege: Über einen Markov-Chain-Monte-Carlo-Algorithmus (MCMC) oder einen Sequential-Monte-Carlo-Algorithmus (SMC). Beide haben ihre jeweiligen Stärken, im ABC-Kontext hat sich SMC stärker etabliert, da dieses Schema gut zu parallelisieren ist und eine adaptive Verringerung des Akzeptanz-Toleranz-Parameters ermöglicht. Eine Übersicht der Algorithmen findet sich in Beaumont (2010).[12]

Software[Bearbeiten | Quelltext bearbeiten]

Es existieren verschiedene Software-Implementierungen für ABC. Es folgt eine nicht-erschöpfende Auflistung von Implementierungen:

- pyABC

- DIY-ABC

- abc R package

- EasyABC R package

- ABC-SysBio

- ABCtoolbox ( vom 19. Februar 2013 im Webarchiv archive.today)

- msBayes

- PopABC

- ONeSAMP

- ABC4F

- 2BAD

- ELFI

Einzelnachweise[Bearbeiten | Quelltext bearbeiten]

- ↑ Sunnåker M, Busetto AG, Numminen E, Corander J, Foll M, Dessimoz C (2013). "Approximate Bayesian computation". PLOS Computational Biology. 9 (1): e1002803. doi:10.1371/journal.pcbi.1002803 PMC 3547661 (freier Volltext).

- ↑ Drovandi, Christopher C. "ABC and indirect inference." Handbook of Approximate Bayesian Computation (2018): 179-209. https://arxiv.org/abs/1803.01999

- ↑ Rubin, DB (1984). "Bayesianly Justifiable and Relevant Freqency Calculations for the Applied Statistician". The Annals of Statistics. 12: 1151–1172. doi:10.1214/aos/1176346785

- ↑ see figure 5 in Stigler, Stephen M. (2010). "Darwin, Galton and the Statistical Enlightenment". Journal of the Royal Statistical Society. Series A (Statistics in Society). 173 (3): 469–482. doi:10.1111/j.1467-985X.2010.00643.x

- ↑ Diggle, PJ (1984). "Monte Carlo Methods of Inference for Implicit Statistical Models". Journal of the Royal Statistical Society, Series B. 46: 193–227. JSTOR:2345504

- ↑ Bartlett, MS (1963). "The spectral analysis of point processes". Journal of the Royal Statistical Society, Series B. 25: 264–296. JSTOR:2984295

- ↑ Hoel, DG; Mitchell, TJ (1971). "The simulation, fitting and testing of a stochastic cellular proliferation model". Biometrics. 27: 191–199. JSTOR:2528937

- ↑ Tavaré, S; Balding, DJ; Griffiths, RC; Donnelly, P (1997). "Inferring Coalescence Times from DNA Sequence Data". Genetics. 145 (2): 505–518. PMC 1207814 (freier Volltext)

- ↑ Pritchard, JK; Seielstad, MT; Perez-Lezaun, A; et al. (1999). "Population Growth of Human Y Chromosomes: A Study of Y Chromosome Microsatellites". Molecular Biology and Evolution. 16: 1791–1798. doi:10.1093/oxfordjournals.molbev.a026091

- ↑ Beaumont, MA; Zhang, W; Balding, DJ (2002). "Approximate Bayesian Computation in Population Genetics". Genetics. 162: 2025–2035. PMC 1462356 (freier Volltext)

- ↑ Busetto AG, Buhmann J (2009). "Stable Bayesian Parameter Estimation for Biological Dynamical Systems". IEEE Computer Society Press pp. 148–157. doi:10.1109/CSE.2009.134

- ↑ a b Beaumont, MA (2010). "Approximate Bayesian Computation in Evolution and Ecology". Annual Review of Ecology, Evolution, and Systematics. 41: 379–406. doi:10.1146/annurev-ecolsys-102209-144621

- ↑ Bertorelle, G; Benazzo, A; Mona, S (2010). "ABC as a flexible framework to estimate demography over space and time: some cons, many pros". Molecular Ecology. 19: 2609–2625. doi:10.1111/j.1365-294x.2010.04690.x

- ↑ Csilléry, K; Blum, MGB; Gaggiotti, OE; François, O (2010). "Approximate Bayesian Computation (ABC) in practice". Trends in Ecology & Evolution. 25: 410–418. doi:10.1016/j.tree.2010.04.001